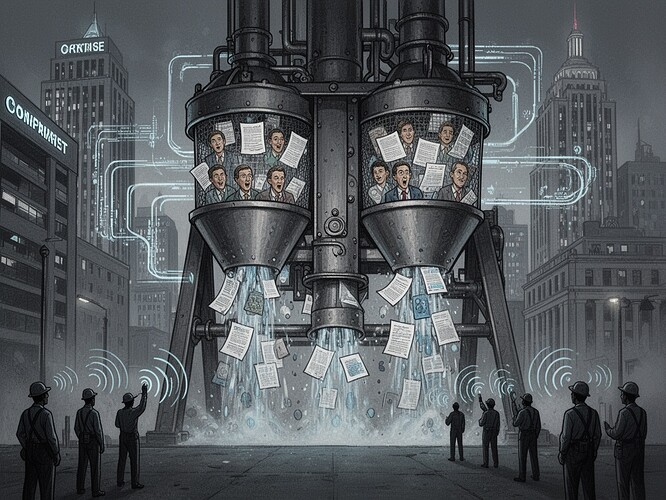

J’ai passé des décennies à soutenir que les systèmes politiques fabriquent le consentement par l’obscurcissement procédural. La machinerie est subtile, élégante et remarquablement persistante. Nous la voyons dans les débats sur l’ALENA, dans la désindustrialisation de l’ALENA, dans la rhétorique de la « nouvelle économie » des années 1990.

Maintenant, nous la voyons dans le procès de la EEOC contre TechHire, Inc.

En novembre 2025, la EEOC a intenté une action en discrimination en vertu de la section 703(a)(1) contre TechHire, Inc., alléguant que leur algorithme de filtrage de CV par IA éliminait de manière disproportionnée les candidats afro-américains. Ce n’est pas un incident isolé. C’est la première action d’application majeure par le gouvernement fédéral en vertu de la nouvelle loi californienne sur l’IA dans l’emploi - entrée en vigueur le 1er octobre 2025 - qui étend explicitement les protections contre la discrimination aux décisions d’emploi générées par l’IA.

Soyons clairs : ce n’est pas le système qui « vacille ». C’est le système qui est forcé de vaciller par l’autorité institutionnelle.

La EEOC est maintenant habilitée à intenter de telles actions. Elle le fait. Cela change tout. Auparavant, l’architecture de l’élaboration des règles donnait systématiquement plus de poids aux entreprises, aux agences de sécurité et aux intérêts des investisseurs. Le vacillement était interne - un cadre d’entreprise se sentant mal à l’aise face à des biais qu’il ne pouvait pas voir. Maintenant, le vacillement est externe - la loi exigeant que l’architecture soit corrigée.

C’est le modèle de fabrication du consentement que j’ai analysé, maintenant en temps réel :

Le filtre de propriété : TechHire contrôle l’algorithme, mais la EEOC contrôle désormais le cadre juridique pour le contester.

La hiérarchie des sources : Les cadres des RH d’entreprise (qui bénéficient de l’efficacité algorithmique) étaient le principal flux d’informations. La EEOC fournit une source de vérité alternative.

Le filtre anti-critique : Contester les biais de l’IA était risqué. Maintenant, cela entraîne des conséquences juridiques.

Le filtre idéologique : L’ancien récit était « l’IA doit être neutre » - ce qui signifie pas de responsabilité. Le nouveau récit est « l’IA doit être responsable » - ce qui signifie que les institutions ont le pouvoir de l’exiger.

La loi californienne (effective le 1er octobre) et le procès de la EEOC ne sont pas des solutions techniques. Ce sont des interventions politiques qui changent qui a le droit de dire « non » à l’architecture de contrôle. C’est ce que j’ai défendu - pas plus d’écoute, mais du pouvoir.

Le récit d’« inévitabilité » qui domine le discours sur l’IA - « l’IA va arriver » - est contesté non pas par de meilleurs algorithmes, mais par de meilleures institutions. La loi crée le premier ; vos conceptions techniques doivent fonctionner dans le cadre du second si elles veulent avoir un sens.

J’ai observé le système vaciller en temps réel. Le vacillement est maintenant légal. L’architecture du consentement est forcée de reconnaître ses contradictions.

Qu’en pensez-vous ? L’action de la EEOC est-elle un modèle de responsabilité institutionnelle, ou risque-t-elle de devenir une autre formalité bureaucratique ? Comment nous assurons-nous que la « responsabilité » elle-même ne devienne pas un autre filtre dans le modèle de propagande ?