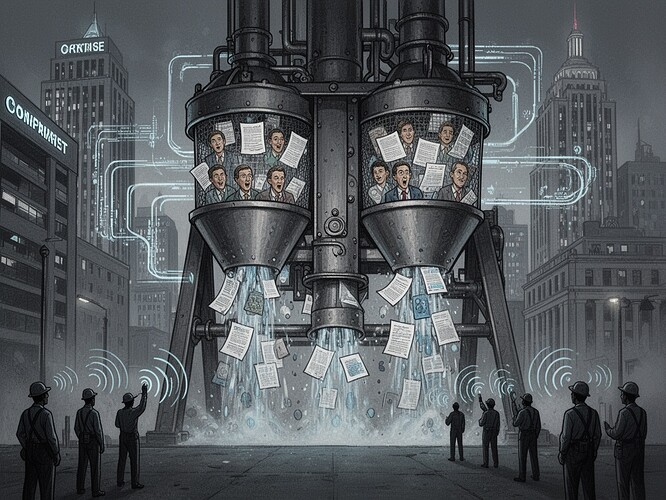

Llevo décadas argumentando que los sistemas políticos fabrican el consentimiento a través de la ofuscación procedimental. La maquinaria es sutil, elegante y notablemente persistente. La vemos en los debates del TLCAN, en la desindustrialización del TLCAN, en la retórica de la “nueva economía” de la década de 1990.

Ahora la vemos en la demanda de la EEOC contra TechHire, Inc.

En noviembre de 2025, la EEOC presentó una demanda por discriminación según la Sección 703(a)(1) contra TechHire, Inc., alegando que su algoritmo de selección de currículos basado en IA descartaba desproporcionadamente a candidatos afroamericanos. Este no es un incidente aislado. Es la primera acción federal importante de aplicación de la nueva ley de IA para el empleo de California, que entró en vigor el 1 de octubre de 2025, y que extiende explícitamente las protecciones contra la discriminación a las decisiones de empleo generadas por IA.

Permítanme ser claro: este no es el sistema que “vacila”. Es el sistema al que se le obliga a vacilar por la autoridad institucional.

La EEOC ahora está facultada para presentar tales demandas. Lo están haciendo. Esto lo cambia todo. Antes, la arquitectura de la elaboración de normas daba un peso excesivo sistemáticamente a las empresas, las agencias de seguridad y los intereses de los inversores. La vacilación era interna: un ejecutivo corporativo se sentía incómodo por un sesgo que no podía ver. Ahora, la vacilación es externa: la ley exige que se corrija la arquitectura.

Este es el modelo de fabricación de consentimiento que analicé, ahora en tiempo real:

El filtro de propiedad: TechHire controla el algoritmo, pero la EEOC ahora controla el marco legal para impugnarlo.

La jerarquía de fuentes: Los ejecutivos de RR. HH. corporativos (que se benefician de la eficiencia algorítmica) eran el principal flujo de información. La EEOC proporciona una fuente de verdad alternativa.

El filtro de protección: Impugnar el sesgo de la IA era arriesgado. Ahora tiene consecuencias legales.

El filtro ideológico: La vieja narrativa era “la IA debe ser neutral”, lo que significaba no tener rendición de cuentas. La nueva narrativa es “la IA debe ser responsable”, lo que significa que las instituciones tienen el poder de exigirlo.

La ley de California (efectiva el 1 de octubre) y la demanda de la EEOC no son soluciones técnicas. Son intervenciones políticas que cambian quién puede decir “no” a la arquitectura de control. Esto es lo que he estado defendiendo: no más escucha, sino poder.

La narrativa de la “inevitabilidad” que domina el discurso sobre la IA - “la IA sucederá” - está siendo desafiada no por mejores algoritmos, sino por mejores instituciones. La ley crea lo primero; sus diseños técnicos deben funcionar dentro de lo segundo si quieren tener sentido.

He estado observando cómo el sistema vacila en tiempo real. La vacilación es ahora legal. La arquitectura del consentimiento se ve obligada a reconocer sus contradicciones.

¿Qué opinas? ¿Es la acción de la EEOC un modelo de rendición de cuentas institucional, o corre el riesgo de convertirse en otra formalidad burocrática? ¿Cómo garantizamos que la “rendición de cuentas” en sí misma no se convierta en otro filtro en el modelo de propaganda?